Почему за гибридными ИИ-системами будущее

Некоторое время назад на Geektimes вышла занимательная статья про критическую оценку результатов глубинного обучения. Статья очень занимательная и интересная, открывает много нового тем, кто интересуется, но не очень-то и погружён в тему Искусственного Интеллекта, искусственных нейронных сетей и глубинного обучения. Так что я рекомендовал бы прочитать сначала её, а потом вернуться к этой моей заметке, которая является своеобразным ответом на эту статью. Но если читать её неохота или нет времени, то вот тезисы:

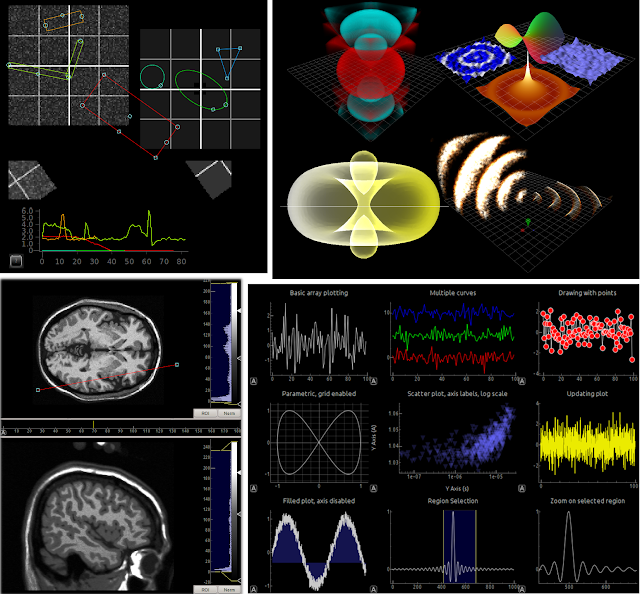

Я уже немного упоминал про гибридный искусственный интеллект. Давайте более детально узнаем, что же это такое. Так что сперва вспомним его общую схему:

Как видно из представленной диаграммы, гибридная искусственная интеллектуальная система представляет собой ни что иное, как универсальную кибернетическую машину, которая имеет три основных элемента: аффекторы, подсистему управления и эффекторы. При помощи аффекторов кибернетическая машина воспринимает сигналы окружающей среды, которые обрабатываются в подсистеме управления, сигналы из которой далее поступают в эффекторы, которые на окружающую среду воздействуют. Это общая схема любого автономного агента, поэтому гибридная искусственная интеллектуальная система одновременно является и интеллектуальным агентом, реализуя агентный подход.

Гибридная интеллектуальная система отличается тем, что её аффекторы (сенсоры, датчики) и эффекторы (исполнительные устройства) связаны с подсистемой управления и принятия решений через нейронные сети. Тем самым используются сильные стороны восходящего, или «грязного» подхода. Аффекторная нейронная сеть принимает очищенные сенсорами сигналы внешней среды и преобразует их в символы, которые подаются на вход универсальной машине вывода. Последняя осуществляет вывод на основе символьных знаний из своей базы знаний и выводит результат, который тоже представляется в виде символов. Тем самым реализуются сильные стороны нисходящего, или «чистого» подход. Символьный результат подаётся на вход моторной нейронной сети, которая преобразует высокоуровневые символы в конкретные сигналы управления исполнительными устройствами.

Кроме всего прочего внутри гибридной интеллектуальной системы должны быть реализованы контрольные связи от всех её элементов к сенсорам. Тем самым реализуются адаптационные механизмы, основанные на гомеостазе внутреннего состояния системы. Сенсоры фиксируют изменение внутреннего состояния каждой подсистемы, их элементов и комплексов, а в случае выхода контролируемых значений за пределы установленных гомеостатических интервалов подсистемой управления принимается решение, целью которого будет возврат изменённых показателей в установочный интервал.

Именно система с такой архитектурой при переходе через определённый порог сложности может считаться разумной. При этом разумность в этом смысле определяется как адекватное реагирование не только на стимулы внешней среды, но и на внутренние состояния, что также включает в себя постоянный мониторинг состояния собственной подсистемы управления, что называется «саморефлексией», которая и приводит к осознанию.

Так что теперь давайте рассмотрим все проблемные места технологии глубинного обучения, данные в оригинальной статье, с точки зрения гибридного подхода.

Однако проблема в том, что даже если нейронная сеть делает подобные обобщения, то их представление скрыто в её глубинах в виде неявной информации, отображаемой только в весовые коэффициенты на связях между нейронами. Интерпретация этих коэффициентов очень затруднительна, если вообще возможна, особенно с учётом того, что одна и та же межнейронная связь может делать вклад в несколько различных правил.

Если рассмотреть пример, приведённый в оригинальной статье, где введено слово «шместра», которое определяется как «сестра, возраст которой от 10 до 21 года», то нейронная сеть вполне может научиться определять, кто шместра, кто просто сестра, а кто вообще ни та, ни другая. Вопрос лишь в обучающей выборке. И после того как нейросеть обучилась, она отлично разделит шмёстр от сестёр, но никогда не сможет объяснить, кто такая шместра и почему она распознаёт шместру в том ли ином случае.

Однако если мы строим гибридную искусственную интеллектуальную систему, то её архитектура может быть устроена так. Сенсорная нейронная сеть определяет базовые параметры входа. Например, то, что на изображении женщина и ей по оценкам 18 лет. Это то, что нейросети сегодня умеют делать очень хорошо. А вот дальше эти распознанные базовые характеристики подаются на вход универсальной машине вывода, в базе знаний которой есть правило «Если женщина является сестрой и ей от 10 до 21 год, то это шместра», после чего запускается процесс вывода — система проверит, является ли распознанная женщина сестрой, и если да, то будет абсолютно ясно, что это шместра. Результат такого вывода может быть объяснён очень просто, спускаясь до базовых характеристик, распознанных нейронной сетью.

И обучение такой гибридной системы может осуществляться как в процессе разработки, так и в процессе взаимодействия с ней. Например, если мы общаемся с ней при помощи диалогового интерфейса (чат-бота), то при использовании в тексте слова «шместра» система может поинтересоваться, что это такое. И тогда можно дать ей определение.

Так что первая проблема систем глубинного обучения довольно легко решается при помощи гибридного подхода.

Фактически, обобщение — это символьная операция. Обобщая, мы переносим найденные закономерности с отдельных экземпляров на типы и классы объектов внешнего мира или абстрактных сущностей. И делается это именно на символьном уровне, когда правила вывода модифицируются при помощи метаправил. Например, одним из таких метаправил может быть такое: «Если несколько объектов одного класса имеют одно и то же свойство, то предположить, что все объекты этого класса имеют это свойство». Классы могут объединяться в классы более высокого порядка, и для них тоже можно делать обобщающие выводы, и так далее. Всё это можно реализовать при помощи самообучающейся универсальной машины вывода, в которой есть метаправила, в том числе и для изменения самих метаправил.

Но для этого необходимо иметь иерархию понятий. Но у систем глубинного обучения реализация иерархий пока очень слабая, так как...

Хотя, к примеру, существуют нейросетевые модели, которые преобразуют последовательности слов в некие «векторы в трёхсотмерном пространстве смыслов, суть которых человеческому сознанию не ясна», которые, вроде как бы даже группируются в какие-то кластеры. Но это опять же не иерархии, а всё такие же векторные преобразования, которыми, по сути, нейросетевые модели и являются.

С другой стороны нисходящая парадигма имеет все средства для нативного представления иерархических понятий. Даже при помощи продукций это можно сделать, не говоря уже о семантических сетях и онтологиях, которые именно для этого и предназначены. Но здесь речь идёт опять о явном представлении знаний и дедуктивном обучении с учителем, хотя вполне возможно построение искусственных интеллектуальных систем, которые обучаются не в специальном режиме обучения, а в процессе взаимодействия с окружающей средой. Главное, чтобы из среды приходило правильное подкрепление.

Так что при использовании гибридного подхода опять можно взять лучшее от обеих парадигм. На нижнем уровне распознающие нейросети будут определять конкретные объекты и понятия, с которыми приходится взаимодействовать системе, а на уровне выше эти распознанные понятия могут укладываться в семантические сети для определения иерархических взаимоотношений и получения обобщённых выводов на основе классов высших порядков, в которые входит распознанный объект. Например, визуальная нейросеть распознаёт лицо мужчины на фотографии, а на верхнем уровне к конкретным характеристикам распознанного лица добавляются не только персональные данные и физические характеристики, но и такие понятия, как «взрослый», «самец», «человек», «примат», «млекопитающее» и все остальные классы, в которые входят все нижележащие объекты иерархии. А далее к ним могут быть применены все правила и метаправила вывода для получения как заключений по конкретной ситуации, так и новых знаний.

Вместе с тем символьный подход в искусственном интеллекте прекрасно справляется с НЕ-факторами. Для этого предназначены разнообразные формализмы от метода Демпстера-Шафера, нечёткой логики Л. Заде и заканчивая мягкими и лингвистическими вычислениями. Эти формализмы позволяют осуществить вывод даже в случае неопределённости высоко степени, получив вполне приемлемые результаты.

Тем не менее, знания обладают ещё и НЕ-факторами другого рода, которые относятся не к конкретной информации, но к знаниям в целом. Это уже упомянутая неполнота, это противоречивость и некорректность, это неадекватность и некоторые другие свойства знания, которые проявляются у людей в разной степени, но характеризуют каждую личность по степени её экспертизы в той или иной области (можно быть экспертом в одной области, обладая всей доступной полнотой знания в ней, и профаном в другой, не имея в ней знаний вообще). Гибридные искусственные интеллектуальные системы могут объединить мощь глубинного обучения для выявления новых знаний в данных и формальные методы обработки НЕ-факторов для работы в условиях неопределённости и неполноты информации.

Эта проблема уже привела к появлению новой парадигмы — XAI, eXplainable Artificial Intelligence (объяснимый искусственный интеллект). XAI должен объяснять свои решения и результаты, а это вполне возможно для гибридных интеллектуальных систем, поскольку в рамках нисходящего подхода объяснение — это одна из ключевых особенностей. Символьные системы всегда могут объяснить результаты вывода, так как известны как правила вывода, так и входные данные. Даже в случае обработки НЕ-факторов знания вполне можно объяснить, как получены те или иные результаты или приняты те или иные решения.

В случае создания и использования гибридных ИИ-систем, сети глубинного обучения готовят для принятия решений универсальным решателем базовую информацию. Фактически, именно на этом уровне и будет заканчиваться «необъяснимое» в работе таких систем. Но человеческое сознание работает примерно так же. Например, если человек видит кошку, то он обычно не может объяснить, как именно он распознал в животном именно кошку (все рационализирующие объяснения на тему «это маленькое животное с острыми ушками и полосатым хвостом» не годятся, так как это именно рационализация пост-фактум). Но далее символ «кошка» и все его над-символы могут участвовать в дальнейшем выводе, и результаты такого вывода могут быть вполне объяснены.

Это значит, что имеет смысл сосредоточиться именно на совмещении двух подходов а это путь к гибридизации нисходящей и восходящей парадигмы. Гибридная ИИ-система по своей природе будет интегрирована со всем корпусом имеющихся знаний.

Вместе с тем формальная логика даёт все необходимые инструменты для определения причинно-следственных связей в результатах наблюдений. Чаще всего приходится использовать аппарат нечёткой логики и теории доверия, поскольку наблюдения или эксперименты обычно никогда не бывают «чистыми». Так что приходится закладывать некоторую нечёткость на то, что в результатах есть примеси невыявленных факторов. Поэтому одновременно применение методов математической статистики (нахождение корреляций) и формальной логики (нахождение причинно-следственных связей) работает вполне хорошо и достоверно.

Технологии глубинного обучения с лёгкостью и непринуждённостью имплементируют статистические методы, но формальная логика — это вотчина символьного подхода. Поэтому для разрешения этой проблемы нейронных сетей опять требуется гибридизация парадигм.

Это, возможно, сродни тем процессам, которые происходят внутри естественного интеллекта. Нейронные сети в нервной системе человека (и даже многих животных) вполне успешно аппроксимируют довольно непростые вычислительные задачи. Как поймать рукой брошенный мяч? Быстро решить систему дифференциальных уравнений второго порядка? Есть большие сомнения в том, что какой-то биохимический процесс в нейронах решает подобные уравнения. Но напротив, нейронные сети вполне успешно аппроксимируют решение таких задач после многочисленных актов обучения. Но попробуйте объяснить, как вы ловите брошенный мяч.

И опять на помощь приходит гибридная парадигма. Не важно, как настроились весовые коэффициенты в нейронной сети. Если сеть обучилась успешно аппроксимировать какой-либо процесс, то на более высоком уровне абстракции такие результаты можно объяснить при помощи применения тех или иных правил (как минимум, объяснить можно так же, как эти результаты объяснил бы человек). И тогда далее можно было бы использовать аппарат какой-либо теории доверия (например, теории Демпстера-Шафера) для получения степени доверия к полученному выводу и его объяснению.

Конечно, методы искусственного интеллекта вообще ещё не так широко применяются, как того хотелось бы. В целом, ИИ войдёт во все сферы жизни человека и общества и изменит их, часто до неузнаваемости. В частности, точно подвергнутся самому серьёзному влиянию следующие аспекты:

✹ ✹ ✹

Всё это говорит лишь об одном — необходимо становиться широким специалистом, имеющим знания в обширном множестве областей. Для создания совершенных ИИ-систем уже недостаточно так просто взять и научиться технологии искусственных нейронных сетей, необходимо погрузиться в методы и технологии искусственного интеллекта, которые были разработаны с самого появления этого направления науки и техники. Иначе дело приведёт к третьей Зиме.

- Для работы систем глубинного обучения необходимо много качественных данных, которые должны быть предварительно очищены и размечены специалистом. Чем глубже степень системы, тем больше данных требуется.

- Системы глубинного обучения работают только с теми типами данных, на которых происходило обучение, и они всё ещё не могут обобщать и переносить найденные закономерности на данные других типов, даже очень близких.

- Системам глубинного обучения очень сложно работать с иерархическими структурами, поэтому обработка языка для них — это очень непростое дело, поскольку естественный язык — это очень глубокая иерархическая структура.

- Как следствие предыдущего системы глубинного обучения с большим трудом воспринимают неточные и нечёткие данные, они часто не видят разницы там, где для человека разница огромна.

- Системы глубинного обучения унаследовали от искусственных нейронных сетей и усугубили проблему высокой сложности (до практической невозможности) объяснения полученных результатов и произведённого вывода.

- Системы глубинного обучения не принимают во внимание уже имеющийся корпус знаний, а заново обучаются на входных данных, просто как-то по-своему их интерпретируя.

- Важной задачей является выявление причинно-следственных связей и отделение их от простых корреляций, но системам глубинного обучения такое разделение пока даётся с трудом.

- Систему глубинного обучения легко обмануть, особенно если она находится на «грани переобученности». Эта уязвимость открывает широкий простор для разнообразных атак, последствия которых ещё даже не до конца осознаны. К решению этой проблемы даже не приступали.

- Прикладных применений системам глубинного обучения так до сих пор и не найдено, и этот пункт является, фактически, следствием всех предыдущих.

Я уже немного упоминал про гибридный искусственный интеллект. Давайте более детально узнаем, что же это такое. Так что сперва вспомним его общую схему:

Как видно из представленной диаграммы, гибридная искусственная интеллектуальная система представляет собой ни что иное, как универсальную кибернетическую машину, которая имеет три основных элемента: аффекторы, подсистему управления и эффекторы. При помощи аффекторов кибернетическая машина воспринимает сигналы окружающей среды, которые обрабатываются в подсистеме управления, сигналы из которой далее поступают в эффекторы, которые на окружающую среду воздействуют. Это общая схема любого автономного агента, поэтому гибридная искусственная интеллектуальная система одновременно является и интеллектуальным агентом, реализуя агентный подход.

Гибридная интеллектуальная система отличается тем, что её аффекторы (сенсоры, датчики) и эффекторы (исполнительные устройства) связаны с подсистемой управления и принятия решений через нейронные сети. Тем самым используются сильные стороны восходящего, или «грязного» подхода. Аффекторная нейронная сеть принимает очищенные сенсорами сигналы внешней среды и преобразует их в символы, которые подаются на вход универсальной машине вывода. Последняя осуществляет вывод на основе символьных знаний из своей базы знаний и выводит результат, который тоже представляется в виде символов. Тем самым реализуются сильные стороны нисходящего, или «чистого» подход. Символьный результат подаётся на вход моторной нейронной сети, которая преобразует высокоуровневые символы в конкретные сигналы управления исполнительными устройствами.

Кроме всего прочего внутри гибридной интеллектуальной системы должны быть реализованы контрольные связи от всех её элементов к сенсорам. Тем самым реализуются адаптационные механизмы, основанные на гомеостазе внутреннего состояния системы. Сенсоры фиксируют изменение внутреннего состояния каждой подсистемы, их элементов и комплексов, а в случае выхода контролируемых значений за пределы установленных гомеостатических интервалов подсистемой управления принимается решение, целью которого будет возврат изменённых показателей в установочный интервал.

Именно система с такой архитектурой при переходе через определённый порог сложности может считаться разумной. При этом разумность в этом смысле определяется как адекватное реагирование не только на стимулы внешней среды, но и на внутренние состояния, что также включает в себя постоянный мониторинг состояния собственной подсистемы управления, что называется «саморефлексией», которая и приводит к осознанию.

Так что теперь давайте рассмотрим все проблемные места технологии глубинного обучения, данные в оригинальной статье, с точки зрения гибридного подхода.

1. Глубинное обучение нуждается в данных

Чем больше данных, особенно качественно размеченных, — тем лучше результат работы глубинных нейронных сетей. Более того, они могут обобщать информацию и находить скрытые зависимости, строя что-то типа продукционных правил «если ..., то ...». Фактически, любая нейросеть при обучении делает это, так как по факту строит правила преобразования входных данных в выходные, что на более высоком уровне абстракции можно представить в виде продукций «Если вход принимает такие-то значения, то выход равен тому-то».Однако проблема в том, что даже если нейронная сеть делает подобные обобщения, то их представление скрыто в её глубинах в виде неявной информации, отображаемой только в весовые коэффициенты на связях между нейронами. Интерпретация этих коэффициентов очень затруднительна, если вообще возможна, особенно с учётом того, что одна и та же межнейронная связь может делать вклад в несколько различных правил.

Если рассмотреть пример, приведённый в оригинальной статье, где введено слово «шместра», которое определяется как «сестра, возраст которой от 10 до 21 года», то нейронная сеть вполне может научиться определять, кто шместра, кто просто сестра, а кто вообще ни та, ни другая. Вопрос лишь в обучающей выборке. И после того как нейросеть обучилась, она отлично разделит шмёстр от сестёр, но никогда не сможет объяснить, кто такая шместра и почему она распознаёт шместру в том ли ином случае.

Однако если мы строим гибридную искусственную интеллектуальную систему, то её архитектура может быть устроена так. Сенсорная нейронная сеть определяет базовые параметры входа. Например, то, что на изображении женщина и ей по оценкам 18 лет. Это то, что нейросети сегодня умеют делать очень хорошо. А вот дальше эти распознанные базовые характеристики подаются на вход универсальной машине вывода, в базе знаний которой есть правило «Если женщина является сестрой и ей от 10 до 21 год, то это шместра», после чего запускается процесс вывода — система проверит, является ли распознанная женщина сестрой, и если да, то будет абсолютно ясно, что это шместра. Результат такого вывода может быть объяснён очень просто, спускаясь до базовых характеристик, распознанных нейронной сетью.

И обучение такой гибридной системы может осуществляться как в процессе разработки, так и в процессе взаимодействия с ней. Например, если мы общаемся с ней при помощи диалогового интерфейса (чат-бота), то при использовании в тексте слова «шместра» система может поинтересоваться, что это такое. И тогда можно дать ей определение.

Так что первая проблема систем глубинного обучения довольно легко решается при помощи гибридного подхода.

2. Глубинное обучение пока что имеет небольшую глубину и плохо переносит полученные знания на другие данные

Системы глубинного обучения находят интересные закономерности, но не могут их обобщить, и отсюда происходят различные смешные казусы, описанные в оригинальной статье. Обобщение — это операция более высокого уровня абстракции, чем простое нахождение закономерностей, даже скрытых. И если с последним нейросети справляются очень даже легко и уже превосходят в этом людей, то с обобщением у них серьёзные проблемы. Впрочем, у многих людей тоже.Фактически, обобщение — это символьная операция. Обобщая, мы переносим найденные закономерности с отдельных экземпляров на типы и классы объектов внешнего мира или абстрактных сущностей. И делается это именно на символьном уровне, когда правила вывода модифицируются при помощи метаправил. Например, одним из таких метаправил может быть такое: «Если несколько объектов одного класса имеют одно и то же свойство, то предположить, что все объекты этого класса имеют это свойство». Классы могут объединяться в классы более высокого порядка, и для них тоже можно делать обобщающие выводы, и так далее. Всё это можно реализовать при помощи самообучающейся универсальной машины вывода, в которой есть метаправила, в том числе и для изменения самих метаправил.

Но для этого необходимо иметь иерархию понятий. Но у систем глубинного обучения реализация иерархий пока очень слабая, так как...

3. У глубинного обучения пока нет естественного способа работы с иерархической структурой

Так как нейронные сети пока с трудом справляются с иерархиями понятий. Попытки представить иерархические структуры в нейросетевых моделях приводят либо к переобучению нейросетей, либо к тому, что они не могут полноценно дифференцировать объекты распознавания при спуске по иерархии вниз. Кое-каких успехов в этом вопросе достигли нейросети именно глубинного обучения, так как в них неявно и самостоятельно образуются иерархии образов, но ведь весь вопрос в том, чтобы вложить в нейросеть некоторую заданную иерархию в явном виде. Пока это вызывает определённые затруднения.Хотя, к примеру, существуют нейросетевые модели, которые преобразуют последовательности слов в некие «векторы в трёхсотмерном пространстве смыслов, суть которых человеческому сознанию не ясна», которые, вроде как бы даже группируются в какие-то кластеры. Но это опять же не иерархии, а всё такие же векторные преобразования, которыми, по сути, нейросетевые модели и являются.

С другой стороны нисходящая парадигма имеет все средства для нативного представления иерархических понятий. Даже при помощи продукций это можно сделать, не говоря уже о семантических сетях и онтологиях, которые именно для этого и предназначены. Но здесь речь идёт опять о явном представлении знаний и дедуктивном обучении с учителем, хотя вполне возможно построение искусственных интеллектуальных систем, которые обучаются не в специальном режиме обучения, а в процессе взаимодействия с окружающей средой. Главное, чтобы из среды приходило правильное подкрепление.

Так что при использовании гибридного подхода опять можно взять лучшее от обеих парадигм. На нижнем уровне распознающие нейросети будут определять конкретные объекты и понятия, с которыми приходится взаимодействовать системе, а на уровне выше эти распознанные понятия могут укладываться в семантические сети для определения иерархических взаимоотношений и получения обобщённых выводов на основе классов высших порядков, в которые входит распознанный объект. Например, визуальная нейросеть распознаёт лицо мужчины на фотографии, а на верхнем уровне к конкретным характеристикам распознанного лица добавляются не только персональные данные и физические характеристики, но и такие понятия, как «взрослый», «самец», «человек», «примат», «млекопитающее» и все остальные классы, в которые входят все нижележащие объекты иерархии. А далее к ним могут быть применены все правила и метаправила вывода для получения как заключений по конкретной ситуации, так и новых знаний.

4. Глубинное обучение до сих пор с трудом работает с неточно определяемыми понятиями

В процессе своей жизнедеятельности люди постоянно сталкиваются с ситуациями, где данные неполны, информация неточна, знания противоречивы, нечётки и неопределённы. Эти так называемые НЕ-факторы знания пронизывают всю информационную ткань нашей реальности уже в силу самой её природы, поскольку точность данных невозможно повысить до бесконечности в силу фундаментальных ограничений. Человеческий разум научился обрабатывать такие ситуации, но системы глубинного обучения нет, поскольку требуют чётко размеченных данных и максимально полный набор значений входных параметров для обучения. Только в последнее время начали появляться комбинированные механизмы для обработки при помощи нейронных сетей знаний с нечёткостью или неопределённостью.

Вместе с тем символьный подход в искусственном интеллекте прекрасно справляется с НЕ-факторами. Для этого предназначены разнообразные формализмы от метода Демпстера-Шафера, нечёткой логики Л. Заде и заканчивая мягкими и лингвистическими вычислениями. Эти формализмы позволяют осуществить вывод даже в случае неопределённости высоко степени, получив вполне приемлемые результаты.

Тем не менее, знания обладают ещё и НЕ-факторами другого рода, которые относятся не к конкретной информации, но к знаниям в целом. Это уже упомянутая неполнота, это противоречивость и некорректность, это неадекватность и некоторые другие свойства знания, которые проявляются у людей в разной степени, но характеризуют каждую личность по степени её экспертизы в той или иной области (можно быть экспертом в одной области, обладая всей доступной полнотой знания в ней, и профаном в другой, не имея в ней знаний вообще). Гибридные искусственные интеллектуальные системы могут объединить мощь глубинного обучения для выявления новых знаний в данных и формальные методы обработки НЕ-факторов для работы в условиях неопределённости и неполноты информации.

5. Глубинное обучение до сих пор недостаточно прозрачно

О «невозможности» интерпретировать результаты обучения нейронных сетей уже рассказано очень много. Тут вопрос не в непознаваемости, а в слишком высокой вычислительной потребности для того, чтобы понять результаты настройки весовых коэффициентов на связях между нейронами, полученных в результате обучения. Если сеть состоит из сотен тысяч нейронов и тысяч слоёв, то количестве весовых коэффициентов на связях просто циклопическое, и «дизассемблирование» результатов обучения просто невыполнимо с вычислительной точки зрения.Эта проблема уже привела к появлению новой парадигмы — XAI, eXplainable Artificial Intelligence (объяснимый искусственный интеллект). XAI должен объяснять свои решения и результаты, а это вполне возможно для гибридных интеллектуальных систем, поскольку в рамках нисходящего подхода объяснение — это одна из ключевых особенностей. Символьные системы всегда могут объяснить результаты вывода, так как известны как правила вывода, так и входные данные. Даже в случае обработки НЕ-факторов знания вполне можно объяснить, как получены те или иные результаты или приняты те или иные решения.

В случае создания и использования гибридных ИИ-систем, сети глубинного обучения готовят для принятия решений универсальным решателем базовую информацию. Фактически, именно на этом уровне и будет заканчиваться «необъяснимое» в работе таких систем. Но человеческое сознание работает примерно так же. Например, если человек видит кошку, то он обычно не может объяснить, как именно он распознал в животном именно кошку (все рационализирующие объяснения на тему «это маленькое животное с острыми ушками и полосатым хвостом» не годятся, так как это именно рационализация пост-фактум). Но далее символ «кошка» и все его над-символы могут участвовать в дальнейшем выводе, и результаты такого вывода могут быть вполне объяснены.

6. Глубинное обучение пока что плохо интегрируется с уже существующими знаниями

Эта проблема является следствием всех перечисленных ранее. Чтобы интегрировать искусственные нейросети с уже накопленными и даже формализованными знаниями, необходимо проделать большую работу по приведению таких знаний в тот вид, который могут воспринять системы глубинного обучения. Однако многие знания уже приведены к виду, в котором их могут воспринять символьные системы, а, значит, и гибридные. И работа по формализации знаний ведётся именно в этом направлении — знания представляются в рамках символьных формализмов, а не размечаются для потребления нейронными сетями.Это значит, что имеет смысл сосредоточиться именно на совмещении двух подходов а это путь к гибридизации нисходящей и восходящей парадигмы. Гибридная ИИ-система по своей природе будет интегрирована со всем корпусом имеющихся знаний.

7. Глубинное обучение пока что не способно автоматически отличать причинно-следственную связь от корреляции

Если честно, то даже люди со своим естественным интеллектом часто не могут отличить причинно-следственную связь от корреляции. Естественный отбор способствовал тому, что неокортекс человека склонен находить причинно-следственные связи там, где их нет и быть не может. С точки зрения эволюции это вполне разумно, так как лучше перебдеть и выжить, чем долго размышлять на тему, является ли одно событие прямым следствием другого. Так что излишняя склонность видеть причинно-следственные связи у людей, скорее всего, является инструментом снижения ошибок второго рода в распознавании образов.Вместе с тем формальная логика даёт все необходимые инструменты для определения причинно-следственных связей в результатах наблюдений. Чаще всего приходится использовать аппарат нечёткой логики и теории доверия, поскольку наблюдения или эксперименты обычно никогда не бывают «чистыми». Так что приходится закладывать некоторую нечёткость на то, что в результатах есть примеси невыявленных факторов. Поэтому одновременно применение методов математической статистики (нахождение корреляций) и формальной логики (нахождение причинно-следственных связей) работает вполне хорошо и достоверно.

Технологии глубинного обучения с лёгкостью и непринуждённостью имплементируют статистические методы, но формальная логика — это вотчина символьного подхода. Поэтому для разрешения этой проблемы нейронных сетей опять требуется гибридизация парадигм.

8. Глубинное обучение пока что хорошо работает в роли аппроксимации, но его ответам часто нельзя полностью доверять

Эта проблема является следствием сложности интерпретации результатов, получаемых на выходе нейронных сетей глубинного обучения, и предыдущей проблемы. Да, глубинное обучение неплохо справляется со статистическими моделями, как это уже было показано. Аппроксимация — это упрощение, замена сложного вычислительного процесса более простым. Если некоторый вычислительный процесс можно хотя бы приблизительно представить в виде произведения матриц, то методами глубинного обучения вполне можно аппроксимировать такой процесс.

Это, возможно, сродни тем процессам, которые происходят внутри естественного интеллекта. Нейронные сети в нервной системе человека (и даже многих животных) вполне успешно аппроксимируют довольно непростые вычислительные задачи. Как поймать рукой брошенный мяч? Быстро решить систему дифференциальных уравнений второго порядка? Есть большие сомнения в том, что какой-то биохимический процесс в нейронах решает подобные уравнения. Но напротив, нейронные сети вполне успешно аппроксимируют решение таких задач после многочисленных актов обучения. Но попробуйте объяснить, как вы ловите брошенный мяч.

И опять на помощь приходит гибридная парадигма. Не важно, как настроились весовые коэффициенты в нейронной сети. Если сеть обучилась успешно аппроксимировать какой-либо процесс, то на более высоком уровне абстракции такие результаты можно объяснить при помощи применения тех или иных правил (как минимум, объяснить можно так же, как эти результаты объяснил бы человек). И тогда далее можно было бы использовать аппарат какой-либо теории доверия (например, теории Демпстера-Шафера) для получения степени доверия к полученному выводу и его объяснению.

9. Глубинное обучение тяжело использовать в прикладных целях

Ну и, наконец, этакая упадническая проблема. На самом деле, проблемы тут нет. Системы глубинного обучения вполне можно применять в различных прикладных задачах, просто сама отрасль ещё достаточно молода, чтобы получить прикладное развитие. Но процессы уже идут. Системы машинного зрения уже давно становятся на службу таких отраслей, как обеспечение безопасности и организация дорожного движения. Распознавание инцидентов на автомобильных дорогах и в зонах контроля видеонаблюдения — самые что ни на есть прикладные задачи. Рекомендации по результатам покупок или лайков в социальных сетях — тоже прикладные задачи, успешно решаемые методами глубинного обучения.Конечно, методы искусственного интеллекта вообще ещё не так широко применяются, как того хотелось бы. В целом, ИИ войдёт во все сферы жизни человека и общества и изменит их, часто до неузнаваемости. В частности, точно подвергнутся самому серьёзному влиянию следующие аспекты:

- Государственное и муниципальное управление.

- Обеспечение личной и общественной безопасности.

- Транспорт и логистика.

- Промышленность.

- Образование.

- Наука.

- Здравоохранение.

- Культура.

✹ ✹ ✹

Всё это говорит лишь об одном — необходимо становиться широким специалистом, имеющим знания в обширном множестве областей. Для создания совершенных ИИ-систем уже недостаточно так просто взять и научиться технологии искусственных нейронных сетей, необходимо погрузиться в методы и технологии искусственного интеллекта, которые были разработаны с самого появления этого направления науки и техники. Иначе дело приведёт к третьей Зиме.

Комментарии

Отправить комментарий